ИИ в руках манипуляторов: как россияне создают фейковую реальность с помощью цифровых технологий

“Покровск ждет вашей поддержки”, “Это защитник, которого забыли поздравить с днем рождения”, “Авдеевка просит вашей молитвы” — такие эмоциональные призывы очень быстро становятся вирусными в социальных сетях. Однако знаете ли вы, что они не являются реальными историями, а лишь продуктом искусственного интеллекта, который активно используется российской пропагандой для распространения выгодных нарративов? Дипфейки с заявлениями политиков, сфабрикованные сцены спасения детей или животных, трогательные истории об украинских военных — все это лишь “вершина айсберга” новых манипуляций кремлевских агитпропов. Подробнее о том, как искусственный интеллект стал инструментом информационной войны, читайте далее в статье.

Российская пропагандистская машина все активнее использует технологии искусственного интеллекта для ведения информационной войны против Украины.

Еще в начале 2024 года OpenAI, одна из ведущих компаний в сфере разработки искусственного интеллекта, обнаружила и сорвала пять масштабных онлайн-кампаний, направленных на манипулирование общественным мнением и влияние на геополитическую ситуацию.

Согласно сообщению издания The New York Times, эти операции были организованы государственными акторами и частными компаниями из россии, Китая, Ирана и Израиля.

В частности, две из обнаруженных компаний, которые действовали в рамках российской пропагандистской машины, активно использовали технологии OpenAI для распространения дезинформации.

“Одна из компаний использовала технологию OpenAI для создания антиукраинских комментариев, которые были размещены в социальной сети «X» на английском, французском, немецком, итальянском и польском языках. Инструменты компании также использовались для перевода и редактирования статей, которые поддерживали россию в войне против Украины, на английском и французском языках, а также для конвертации антиукраинских новостных статей в сообщения для Facebook”, — говорится в статье The New York Times.

Исполнительный директор Института информационной безопасности Артем Биденко отметил, что россия очень активно использует искусственный интеллект с его большими возможностями.

“Россия сегодня максимально и фактически бесконтрольно использует цифровую пропаганду с искусственным интеллектом и его большими возможностями для различных картинок, мемов, видео и новостей. Речь идет о сотнях тысяч псевдоновостей или мемов. И ни одна сеть не способна преодолевать это. Россия с помощью таких примитивных инструментов не коммуницирует с аудиторией рационально, а просто заваливает ее огромным количеством лживой информации. У людей, которые легко поддаются пропаганде, она откладывается и формирует искаженное отношение к тому, что происходит в Украине”, — пояснил эксперт.

Российские “щупальца” пропаганды в TikTok

Социальные сети буквально заполонили сообщения, созданные с помощью искусственного интеллекта, целью которых является вызвать эмоциональные реакции у пользователей. Одним из наиболее распространенных примеров являются видео и изображения, которые активно публикуют в TikTok, где якобы призывают молиться за украинских военных, спасенных животных или детей.

Подобные сообщения часто создаются таким образом, чтобы вызвать сочувствие или другие сильные эмоции. Благодаря этому публикации набирают популярность, их контент распространяется быстро, а аккаунты или страницы получают большую аудиторию.

Почти все публикации в TikTok, которые распространяют контент, сгенерированный ИИ, имеют общие черты:

❌Неизвестный владелец страницы

Большинство таких профилей не содержат никакой информации, которая позволила бы установить реальное лицо или организацию, которая за ними стоит. Имена аккаунтов часто указаны на русском языке или являются случайным набором букв и цифр. Анонимность позволяет скрыть истинное происхождение контента и создает иллюзию обычного пользователя, который просто делится своими мыслями или эмоциями.

❌ Типичные ошибки ИИ

Контент имеет явные признаки искусственного происхождения, которые можно распознать даже невооруженным глазом. Например, неестественные размеры частей тела или объектов, неправильное расположение теней, неуместные блики или слияние элементов, резкие переходы или размытие цветовых зон, повторяющиеся элементы, которые выглядят как “клоны” на изображении.

❌ Эмоциональная подпись

Подписи к публикациям обычно эмоционально окрашены, что вызывает сочувствие, возмущение или гордость, провоцируя пользователей на активные реакции.

❌Призыв к взаимодействию

Характерной чертой манипулятивного контента является просьба к аудитории ставить лайки, распространять контент или оставлять комментарии. Часто это формулируется через фразы вроде “поблагодарите героев”, “распространите это, чтобы больше людей увидели”, или “не оставайтесь равнодушными”. Такие призывы работают как триггер, который стимулирует аудиторию к действиям и обеспечивает быстрое распространение контента в сети.

На первый взгляд, патриотические публикации кажутся невинными или даже благородными, ведь они вызывают сочувствие, чувство поддержки и единства. Однако за яркими призывами нередко скрывается хорошо продуманная схема манипуляции и обмана, которая может иметь серьезные последствия. Так как же работает этот механизм?

Эксперты Центра противодействия дезинформации Украины объясняют, что сначала с помощью искусственного интеллекта фейкодел создает эмоционально заряженные, кликбейтные картинки с призывами к поддержке, которые стимулируют пользователей подписаться на аккаунт или распространить публикацию.

Благодаря эмоциональной составляющей эти сообщения привлекают внимание и пользуются значительной популярностью среди аудитории, что способствует активному привлечению аудитории.

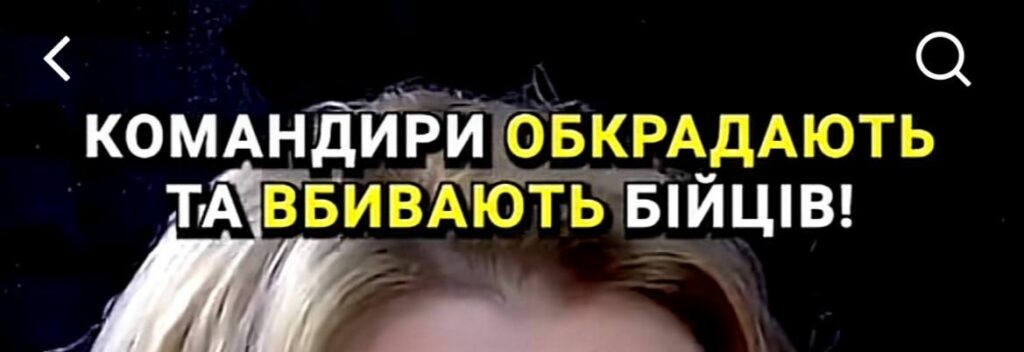

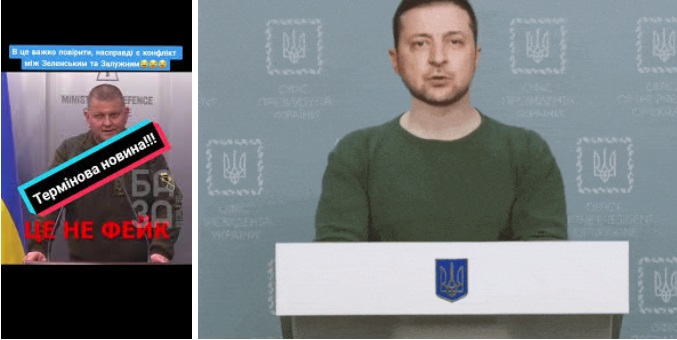

Еще один пример манипулятивной подписи с целью дискредитации украинского военного командования и власти. Скриншот из социальной сети “TikTok”

После того, как страница достигает определенного количества подписчиков, ее владелец может удалить весь предыдущий контент, включая “патриотические публикации”, и начать вести профиль уже с другими целями. Это может быть, например, содействие продвижению пропагандистских нарративов, выгодных россии, или же даже продажа страницы с уже собранной активной аудиторией.

Кроме того, подобные аккаунты могут содержать вредоносные ссылки, которые ведут к мошенническим ресурсам, где пользователи могут стать жертвами киберпреступлений.

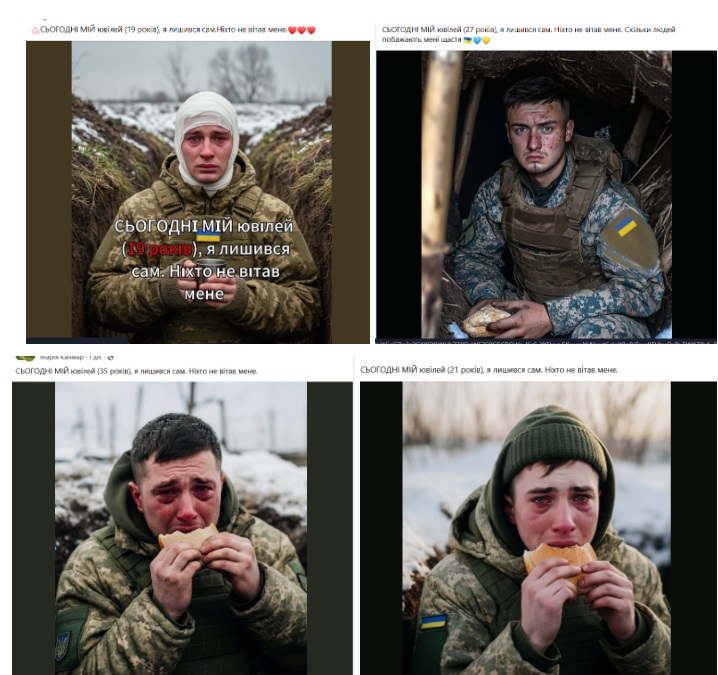

“Авдеевка просит молитвы”, “Засыпанные снегом военные”, “Сегодня мой юбилей, я остался один” — ИИ-изображения

Кроме TikTok, сгенерированные искусственным интеллектом изображения и сообщения активно распространяются в других популярных социальных сетях, таких как Facebook, Instagram, Telegram и Twitter. Эти платформы стали удобной площадкой для создания и распространения фейкового контента, ориентированного на вызов эмоционального отклика и привлечения аудитории.

Ведь именно в Facebook и Instagram, например, алгоритмы поощряют публикации, которые активно комментируют, лайкают или распространяют. Это открывает путь для вирусного контента, который часто базируется на визуальных триггерах — фото, которые вызывают сочувствие, гордость или другие сильные эмоции.

Подписи к таким изображениям обычно содержат призывы к действию:

❌ “Поздравьте нашего героя с днем рождения!”

❌ “Распространите, если не равнодушны к подвигам наших защитников!”

❌ “Сегодня мой юбилей, я остался один. Никто не поздравил меня”

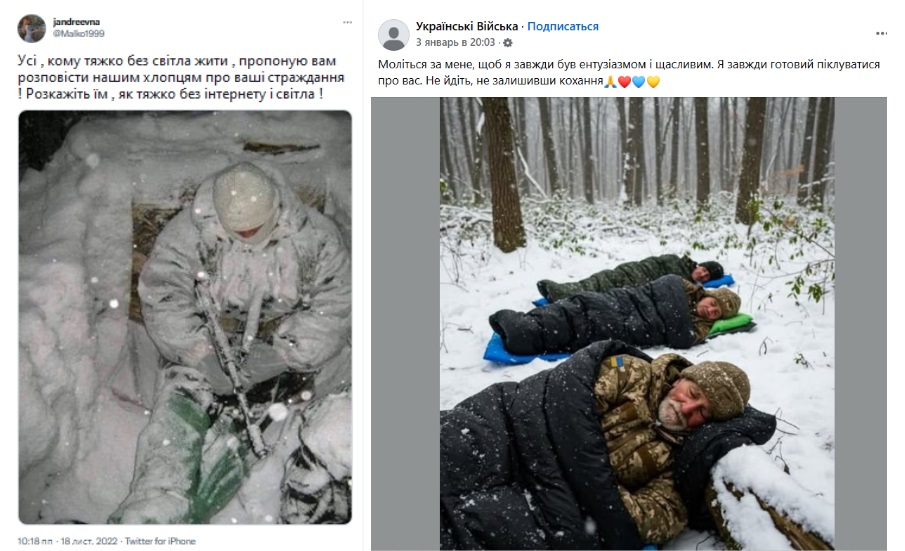

Некоторые из подобных сгенерированных изображений успели действительно наделать большого резонанса в обществе и были неоднократно разоблачены украинскими фактчекерами. Среди них — фотофейк, где военный спит в снегу (несколько лет подряд на подобном фото был российский оккупант, однако из-за манипулятивной подписи украинцы распространяли то фото со словами благодарности и молитвы ВСУ).

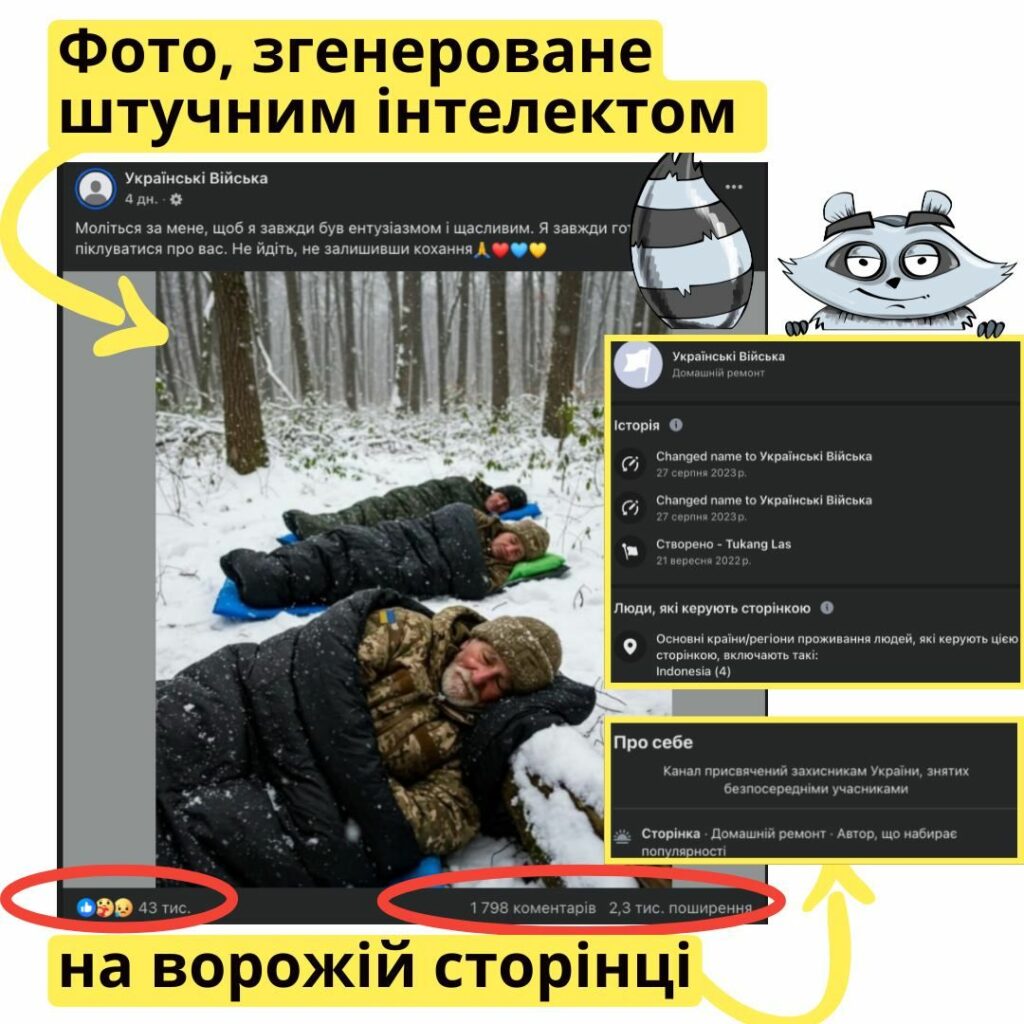

В этом же году завирусилось изображение, сгенерированное искусственным интеллектом, на котором уже трое военных спят на снегу.

Фактчекинговая инициатива “НотаЕнота” обнаружила, что изображение было создано искусственным интеллектом, а сама страница, которая распространяла этот контент, была создана в Индонезии и перепродана в августе 2023 года с названием “Украинские войска”.

Стоит также упомянуть волну публикаций 2023 года, в которых призывали молиться за спасение украинских военных в Авдеевке. Изображения, сопровождаемые подписями типа “Авдеевка просит молитвы”, распространялись в социальных сетях и имели значительный эмоциональный отклик.

Подобные публикации, как и те, что распространяются в TikTok, имеют одну общую цель — вызвать эмоциональную реакцию и побудить людей к активным действиям, таким как комментарии, лайки и распространение. Эти сообщения часто распространяются ботами или автоматическими аккаунтами, что помогает быстро продвигать страницы и увеличивать их популярность.

В частности, на страницах с ИИ-изображениями собирается большая аудитория, которая не слишком критично относится к увиденному в сети и является уязвимой к информационным манипуляциям.

Дипфейки

Одним из важных элементов в стратегии использования новейших цифровых инструментов россией также являются так называемые дипфейки. Дипфейк — это искусственно созданные видео или аудио материалы, которые выглядят очень реалистично и создаются с помощью технологий искусственного интеллекта, которые позволяют манипулировать изображениями, голосами и даже выражениями лица.

Вы, наверное, помните видео, которое появилось в самом начале полномасштабного вторжения, на котором Владимир Зеленский якобы рассказывает о том, как “трудно управлять страной”, и “объявляет” о капитуляции Украины в войне с россией.

Другим, не менее резонансным, примером является фейковое видео с изображением “генерала Залужного”, который обвиняет украинское руководство в гибели своего помощника и призывает украинцев выйти на улицы своих городов, а военных — не подчиняться “преступным приказам” власти.

Такие манипуляции, в первую очередь, ставят целью дестабилизировать ситуацию внутри страны, посеять хаос и раскол среди населения и военных.

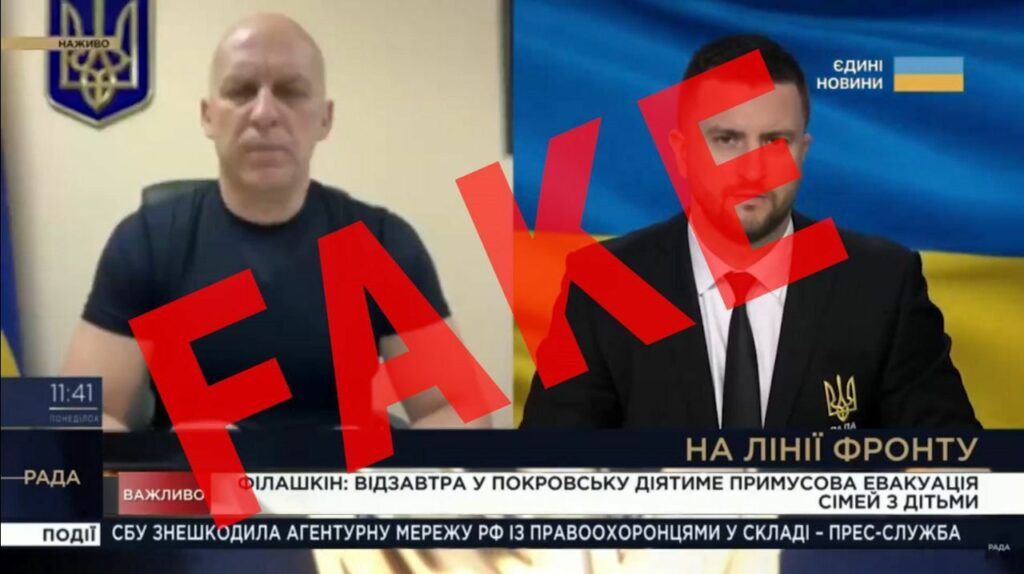

Кроме этого, осенью 2024 года россияне начали массово распространять якобы видеообращение с комментарием начальника Донецкой ОВА Вадима Филашкина о том, что в Покровске местные жители организовывают митинги против ВСУ, конфликтуют с военными, а потому в громаде будет проведена принудительная эвакуация населения.

Сам начальник ДонОВА отреагировал на это в личном телеграм-канале и заявил, что голос на видео ему не принадлежит, а озвученная информация повторяет российские пропагандистские нарративы и призвана вызвать напряжение в обществе. Подробнее об этом, вместе с рекомендациями, как уберечься от дипфейка, Восточный Вариант уже писал ранее в материале.

Российские щупальца пропаганды активно используют все доступные инструменты, стремясь проникнуть даже в самые маленькие щели информационного пространства. Это включает в себя манипуляции через дипфейки, фальшивые новости и другие технологии, которые могут заставить сомневаться в реальности событий.

Вот несколько советов, как не попасть на крючок пропагандистского контента:

✅Проверяйте источник информации;

✅ Внимательно относитесь к деталям в видео и аудио: технические манипуляции в дипфейках часто проявляются через невыразительные или неестественные движения губ, взгляд или аномальные шумы в аудиотреках.

✅ Будьте осторожны с эмоционально окрашенными сообщениями: пропагандистский контент часто направлен на вызов эмоциональной реакции (страх, гнев, разочарование). Если сообщение вызывает сильные эмоции — вероятнее всего этот контент является манипулятивным.

***

Проверь свои знания: Правда или фейк? Тест на умение распознавать дезинформацию

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Александр Глущенко: Доступ к правде — это уже сопротивление

Эксклюзив Эвакуация с ВОТ: какие документы нужны

PR Как выбрать идеальный корм для вашего пушистого друга

Наши дроны становятся более устойчивыми к РЭБ, способны видеть противника и днем, и ночью, — Сырский (видео)

В оккупированном Мариуполе сообщили о ботулизме и непроверенной рыбе

Актуально Как работает образовательный центр «Вулик» для детей из пострадавших от войны громад

Защитник Мариуполя "Волына" встретился с обладателем "Оскара" Шоном Пенном

Продолжаются российские штурмы: сегодня уже произошло 83 боевых столкновения

Ночью взрывная волна задела жилые кварталы Дружковки (фото)

Эксклюзив Военные рассказали о боях в день "пасхального перемирия" на руинах Торецка

В результате российского обстрела окрестностей Краматорска пострадала 16-летняя девушка

В Часовом Яру уничтожен противотанковый ракетный комплекс и станция наземной разведки оккупантов (видео)

В Киеве переселенцы с Луганщины смогут получить пенсионные консультации 25 апреля

Гира Юлія

Гира Юлія